編者按:近一年來,Transformer 在計算機視覺領域所帶來的革命性提升,引起了學術界的廣泛關注,有越來越多的研究人員投入其中。Transformer 的特點和優勢是什麼?為什麼在計算機領域中 Transformer 可以頻頻出圈?讓我們透過今天的文章來一探究竟吧!

“統一性”是很多學科共同追求的目標,例如在物理學領域,科學家們追求的大統一,就是希望用單獨一種理論來解釋力與力之間的相互作用。人工智慧領域自然也存在著關於“統一性”的目標。在深度學習的浪潮中,人工智慧領域已經朝著統一性的目標前進了一大步。比如,一個新的任務基本都會遵循同樣的流程對新資料進行預測:收集資料,做標註,定義網路結構,訓練網路引數。

但是,在人工智慧的不同子領域中,基本建模的方式各種各樣,並不統一,例如:在自然語言處理(NLP)領域目前的主導建模網路是 Transformer;計算機視覺(CV)領域很長一段時間的主導網路是卷積神經網路(CNN);社交網路領域目前的主導網路則是圖網路等。

儘管如此,從2020年年底開始,Transformer 還是在 CV 領域中展現了革命性的效能提升。這就表明 CV 和 NLP 有望統一在 Transformer 結構之下。這一趨勢對於兩個領域的發展來說有很多好處:1)使視覺和語言的聯合建模更容易;2)兩個領域的建模和學習經驗可以深度共享,從而加快各自領域的進展。

Transformer 在視覺任務中的優異效能

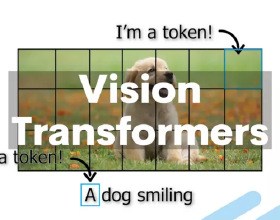

視覺 Transformer 的先驅工作是谷歌在 ICLR 2021 上發表的 ViT [1],該工作把影象分成多個影象塊(例如16x16畫素大小),並把這些影象塊比作 NLP 中的 token。然後直接將 NLP 中的標準 Transformer 編碼器應用於這些 “token”,並據此進行影象分類。該工作結合了海量的預訓練資料(如谷歌內部3億圖片分類訓練庫 JFT-300M),在 ImageNet-1K 的 validation 評測集上取得了88.55%的準確率,重新整理了該榜單上的紀錄。

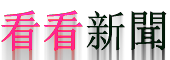

ViT 應用 Transformer 比較簡單直接,因為其沒有仔細考慮視覺訊號本身的特點,所以它主要適應於影象分類任務,對於區域級別和畫素級別的任務並不是很友好,例如物體檢測和語義分割等。為此,學術界展開了大量的改進工作。其中,Swin Transformer 骨幹網路 [2] 在物體檢測和語義分割任務中大幅重新整理了此前的紀錄,讓學術界更加確信 Transformer 結構將會成為視覺建模的新主流。

具體而言,在物體檢測的重要評測集 COCO 上,Swin Transformer 取得了單模型58.7的 box mAP 和51.1的 mask mAP,分別比此前最好的、沒有擴充資料的單模型方法高出了+2.7個點和+2.6個點。此後,透過改進檢測框架以及更好地利用資料,基於 Swin Transformer 網路的方法效能進一步取得了61.3的 box mAP 和53.0的 mask mAP,累計提升達+5.3 box mAP 和+5.5 mask mAP。在語義分割的重要評測資料集 ADE20K 上,Swin Transformer 也取得了顯著的效能提升,達到了53.5 mIoU,比此前最好的方法高出+3.2 mIoU,此後隨著分割框架和訓練方法的進一步改進,目前已達到57.0 mIoU 的效能。

除了在物體檢測和語義分割任務上表現亮眼外,基於 Swin Transformer 骨幹網路的方法在眾多視覺任務中也取得了優異的成績,如影片動作識別 [3]、視覺自監督學習 [4][5]、影象復原 [6]、行人 Re-ID [7]、醫療影象分割 [8]等。

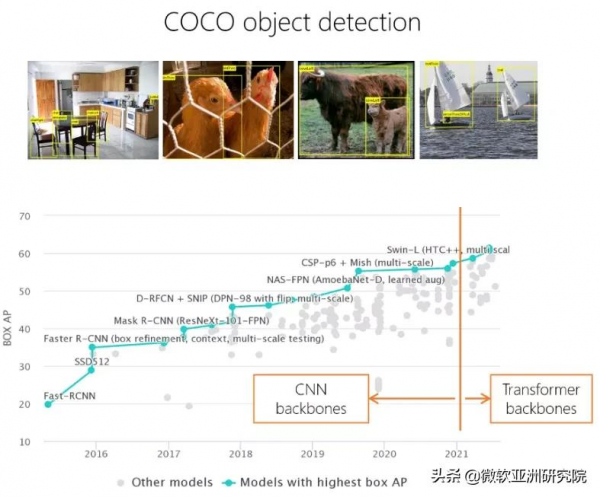

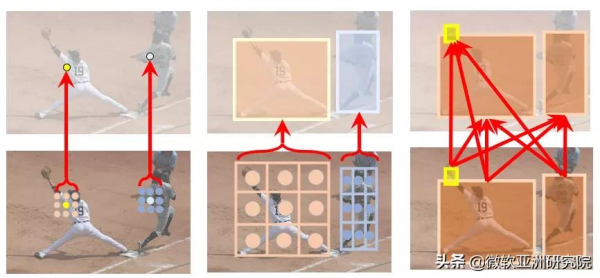

Swin Transformer 的主要思想是將具有很強建模能力的 Transformer 結構和重要的視覺訊號先驗結合起來。這些先驗具有層次性(Hierarchy)、區域性性(locality)以及平移不變性的特點(translation invariance)。Swin Transformer 的一個重要設計是移位的不重疊視窗(shifted windows),不同於傳統的滑動窗,不重疊視窗的設計對硬體實現更加友好,從而具有更快的實際執行速度。如圖2(左)所示,在滑動視窗設計中,不同的點採用了不同的鄰域視窗來計算相互關係,這種計算對硬體並不友好。而如圖2(右)所示,Swin Transformer 使用的不重疊視窗中,統一視窗內的點將採用相同的鄰域來進行計算,對速度更友好。實際測試表明,非重疊視窗方法的速度比滑動視窗方法快了2倍左右。在兩個連續的層中還做了移位的操作。在 L 層中,視窗分割槽從影象的左上角開始;在 L+1 層中,視窗劃分則往右下移動了半個視窗。這樣的設計保證了不重疊的視窗間可以有資訊的交換。

圖2:傳統的滑動視窗方法(左),由於不同的查詢所用到的關鍵字集合不同,其對儲存的訪問不太友好,實際執行速度較慢。移位的不重疊視窗方法(右),由於不同的查詢共享關鍵字集合,所以實際執行速度更快,從而更實用。

在過去的大半年中,學術界視覺 Transformer 還湧現了大量變種,包括 DeiT [9],LocalViT [10],Twins [11],PvT [12],T2T-ViT [13], ViL [14],CvT [15],CSwin [16],Focal Transformer [17],Shuffle Transformer [18] 等。

擁抱 Transformer 的五個理由

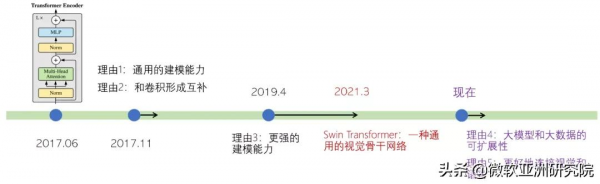

除了重新整理很多視覺任務的效能紀錄以外,視覺 Transformer 還擁有諸多好處。事實上,過去4年間學術界不斷挖掘出了 Transformer 建模的各種優點,可以總結為圖3所示的五個方面。

圖3:過去4年學術界不斷挖掘出的 Transformer 建模的五個優點

理由1:通用的建模能力

Transformer 的通用建模能力來自於兩個方面:一方面 Transformer 可以看作是一種圖建模方法。圖是全連線的,節點之間的關係透過資料驅動的方式來學習得到。由於任意概念(無論具體或抽象)都可以用圖中的節點來表示,且概念之間的關係可以用圖上的邊來刻畫,因此 Transformer 建模具有很強的通用性。

另一方面,Transformer 透過驗證的哲學來建立圖節點之間的關係,具有較好的通用性:無論節點多麼異構,它們之間的關係都可以透過投影到一個可以比較的空間裡計算相似度來建立。如圖4(右)所示,節點可以是不同尺度的影象塊,也可以是“運動員”的文字輸入,Transformer 均可以刻畫這些異構節點之間的關係。

圖4:促成 Transformer 通用建模能力的兩大原因:圖建模(左)和驗證哲學(右)

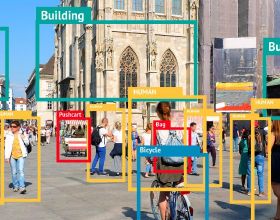

正是因為具備這樣的通用建模能力,Transformer 中的注意力單元可以被應用到各種各樣的視覺任務中。具體而言,計算機視覺處理的物件主要涉及兩個層次的基本元素:畫素和物體。而計算機視覺所涉及到的任務主要就囊括了這些基本元素之間的關係,包括畫素-畫素,物體-畫素和物體-物體的關係建模。此前,前兩種關係建模主要是分別由卷積和 RoIAlign 來實現的,最後一種關係通常沒有很好的建模方法。但是,Transformer 中的注意力單元因其通用的建模能力,可以被應用到所有這些基本關係的建模中。

近些年,在這個領域中已經出現了很多代表性的工作,例如:1) 非區域性網路 [19]。王小龍等人將注意力單元用於建模畫素-畫素的關係,證明了 Transformer 可以幫助影片動作分類和物體檢測等任務。元玉慧等人將其應用於語義分割問題,也取得了顯著的效能提升[20]。2)物體關係網路 [21]。注意力單元用於物體檢測中的物體關係建模,這一模組也被廣泛應用於影片物體分析中 [22, 23, 24]。3)物體和畫素的關係建模,典型的工作包括 DETR [25],LearnRegionFeat [26],以及 RelationNet++ [27]等。

圖5:Transformer 能被應用於各種視覺基本元素之間的關係建模

Transformer 能被應用於各種視覺基本元素之間的關係建模,包括畫素-畫素(左),物體-畫素(中),物體-物體(右)

理由2:和卷積形成互補

卷積是一種區域性操作,一個卷積層通常只會建模鄰域畫素之間的關係。Transformer 則是全域性操作,一個 Transformer 層能建模所有畫素之間的關係,雙方可以很好地進行互補。最早將這種互補性聯絡起來的是非區域性網路 [19],在這個工作中,少量 Transformer 自注意單元被插入到了原始網路的幾個地方,作為卷積網路的補充,並被證明其在物體檢測、語義分割和影片動作識別等問題中廣泛有效。

此後,也有工作發現非區域性網路在視覺中很難真正學到畫素和畫素之間的二階關係 [28],為此,有研究員們也提出了一些針對這一模型的改進,例如解耦非區域性網路 [29]。

理由3:更強的建模能力

卷積可以看作是一種模板匹配,影象中不同位置採用相同的模板進行濾波。而 Transformer 中的注意力單元則是一種自適應濾波,模板權重由兩個畫素的可組合性來決定,這種自適應計算模組具有更強的建模能力。

最早將 Transformer 這樣一種自適應計算模組應用於視覺骨幹網路建模的方法是區域性關係網路 LR-Net [30] 和 SASA [31],它們都將自注意的計算限制在一個區域性的滑動視窗內,在相同理論計算複雜度的情況下取得了相比於 ResNet 更好的效能。然而,雖然理論上與 ResNet 的計算複雜度相同,但在實際使用中它們卻要慢得多。一個主要原因是不同的查詢(query)使用不同的關鍵字(key)集合,如圖2(左)所示,對記憶體訪問不太友好。

Swin Transformer 提出了一種新的區域性視窗設計——移位視窗(shifted windows)。這一區域性視窗方法將影象劃分成不重疊的視窗,這樣在同一個視窗內部,不同查詢使用的關鍵字集合將是相同的,進而可以擁有更好的實際計算速度。在下一層中,視窗的配置會往右下移動半個視窗,從而構造了前一層中不同視窗畫素間的聯絡。

理由4:對大模型和大資料的可擴充套件性

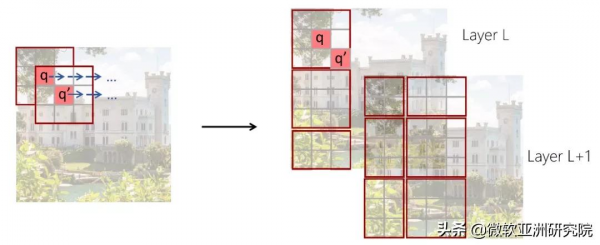

在 NLP 領域,Transformer 模型在大模型和大資料方面展示了強大的可擴充套件性。圖6中,藍色曲線顯示近年來 NLP 的模型大小迅速增加。大家都見證了大模型的驚人能力,例如微軟的 Turing 模型、谷歌的 T5 模型以及 OpenAI 的 GPT-3 模型。

視覺 Transformer 的出現為視覺模型的擴大提供了重要的基礎,目前最大的視覺模型是谷歌的150億引數 ViT-MoE 模型 [32],這些大模型在 ImageNet-1K 分類上重新整理了新的紀錄。

理由5:更好地連線視覺和語言

在以前的視覺問題中,科研人員通常只會處理幾十類或幾百類物體類別。例如 COCO 檢測任務中包含了80個物體類別,而 ADE20K 語義分割任務包含了150個類別。視覺 Transformer 模型的發明和發展,使視覺領域和 NLP 領域的模型趨同,有利於聯合視覺和 NLP 建模,從而將視覺任務與其所有概念聯絡起來。這方面的先驅性工作主要有 OpenAI 的 CLIP [33] 和 DALL-E 模型 [34]。

考慮到上述的諸多優點,相信視覺 Transformer 將開啟計算機視覺建模的新時代,我們也期待學術界和產業界共同努力,進一步挖掘和探索這一新的建模方法給視覺領域帶來的全新機遇和挑戰。

參考文獻:

[1] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, Neil Houlsby. An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale. ICLR 2021

[2] Ze Liu, Yutong Lin, Yue Cao, Han Hu, Yixuan Wei, Zheng Zhang, Stephen Lin, Baining Guo. Swin Transformer: Hierarchical Vision Transformer using Shifted Windows. ICCV 2021

[3] Ze Liu, Jia Ning, Yue Cao, Yixuan Wei, Zheng Zhang, Stephen Lin, Han Hu. Video Swin Transformer. Tech report 2021

[4] Zhenda Xie, Yutong Lin, Zhuliang Yao, Zheng Zhang, Qi Dai, Yue Cao, Han Hu. Self-Supervised Learning with Swin Transformers. Tech report 2021

[5] Chunyuan Li, Jianwei Yang, Pengchuan Zhang, Mei Gao, Bin Xiao, Xiyang Dai, Lu Yuan, Jianfeng Gao. Efficient Self-supervised Vision Transformers for Representation Learning. Tech report 2021

[6] Jingyun Liang, Jiezhang Cao, Guolei Sun, Kai Zhang, Luc Van Gool, Radu Timofte. SwinIR: Image Restoration Using Swin Transformer. Tech report 2021

[7] https://github.com/layumi/Person_reID_baseline_pytorch

[8] Hu Cao, Yueyue Wang, Joy Chen, Dongsheng Jiang, Xiaopeng Zhang, Qi Tian, Manning Wang. Swin-Unet: Unet-like Pure Transformer for Medical Image Segmentation. Tech report 2021

[9] Hugo Touvron, Matthieu Cord, Matthijs Douze, Francisco Massa, Alexandre Sablayrolles, Hervé Jégou. Training data-efficient image transformers & distillation through attention. Tech report 2021

[10] Yawei Li, Kai Zhang, Jiezhang Cao, Radu Timofte, Luc Van Gool. LocalViT: Bringing Locality to Vision Transformers. Tech report 2021

[11] Xiangxiang Chu, Zhi Tian, Yuqing Wang, Bo Zhang, Haibing Ren, Xiaolin Wei, Huaxia Xia, Chunhua Shen. Twins: Revisiting the Design of Spatial Attention in Vision Transformers. Tech report 2021

[12] Wenhai Wang, Enze Xie, Xiang Li, Deng-Ping Fan, Kaitao Song, Ding Liang, Tong Lu, Ping Luo, Ling Shao. Pyramid Vision Transformer: A Versatile Backbone for Dense Prediction without Convolutions. ICCV 2021

[13] Li Yuan, Yunpeng Chen, Tao Wang, Weihao Yu, Yujun Shi, Zihang Jiang, Francis EH Tay, Jiashi Feng, Shuicheng Yan. Tokens-to-Token ViT: Training Vision Transformers from Scratch on ImageNet. Tech report 2021

[14] Pengchuan Zhang, Xiyang Dai, Jianwei Yang, Bin Xiao, Lu Yuan, Lei Zhang, Jianfeng Gao. Multi-Scale Vision Longformer: A New Vision Transformer for High-Resolution Image Encoding. Tech report 2021

[15] Haiping Wu, Bin Xiao, Noel Codella, Mengchen Liu, Xiyang Dai, Lu Yuan, Lei Zhang. CvT: Introducing Convolutions to Vision Transformers. ICCV 2021

[16] Xiaoyi Dong, Jianmin Bao, Dongdong Chen, Weiming Zhang, Nenghai Yu, Lu Yuan, Dong Chen, Baining Guo. CSWin Transformer: A General Vision Transformer Backbone with Cross-Shaped Windows. Tech report 2021

[17] Jianwei Yang, Chunyuan Li, Pengchuan Zhang, Xiyang Dai, Bin Xiao, Lu Yuan, Jianfeng Gao. Focal Self-attention for Local-Global Interactions in Vision Transformers. Tech report 2021

[18] Zilong Huang, Youcheng Ben, Guozhong Luo, Pei Cheng, Gang Yu, Bin Fu. Shuffle Transformer: Rethinking Spatial Shuffle for Vision Transformer. Tech report 2021

[19] Xiaolong Wang, Ross Girshick, Abhinav Gupta, Kaiming He. Non-local Neural Networks. CVPR 2018

[20] Yuhui Yuan, Lang Huang, Jianyuan Guo, Chao Zhang, Xilin Chen, Jingdong Wang. OCNet: Object Context for Semantic Segmentation. IJCV 2021

[21] Han Hu, Jiayuan Gu, Zheng Zhang, Jifeng Dai, Yichen Wei. Relation Networks for Object Detection. CVPR 2018

[22] Jiarui Xu, Yue Cao, Zheng Zhang, Han Hu. Spatial-Temporal Relation Networks for Multi-Object Tracking. ICCV 2019

[23] Yihong Chen, Yue Cao, Han Hu, Liwei Wang. Memory Enhanced Global-Local Aggregation for Video Object Detection. CVPR 2020

[24] Jiajun Deng, Yingwei Pan, Ting Yao, Wengang Zhou, Houqiang Li, and Tao Mei. Relation distillation networks for video object detection. ICCV 2019

[25] Nicolas Carion, Francisco Massa, Gabriel Synnaeve, Nicolas Usunier, Alexander Kirillov, Sergey Zagoruyko. End-to-End Object Detection with Transformers. ECCV 2020

[26] Jiayuan Gu, Han Hu, Liwei Wang, Yichen Wei, Jifeng Dai. Learning Region Features for Object Detection. ECCV 2018

[27] Cheng Chi, Fangyun Wei, Han Hu. RelationNet++: Bridging Visual Representations for Object Detection via Transformer Decoder. NeurIPS 2020

[28] Yue Cao, Jiarui Xu, Stephen Lin, Fangyun Wei, Han Hu. GCNet: Non-local Networks Meet Squeeze-Excitation Networks and Beyond. ICCV workshop 2019

[29] Minghao Yin, Zhuliang Yao, Yue Cao, Xiu Li, Zheng Zhang, Stephen Lin, Han Hu. Disentangled Non-Local Neural Networks. ECCV 2020

[30] Han Hu, Zheng Zhang, Zhenda Xie, Stephen Lin. Local Relation Networks for Image Recognition. ICCV 2019

[31] Prajit Ramachandran, Niki Parmar, Ashish Vaswani, Irwan Bello, Anselm Levskaya, Jonathon Shlens. Stand-Alone Self-Attention in Vision Models. NeurIPS 2019

[32] Carlos Riquelme, Joan Puigcerver, Basil Mustafa, Maxim Neumann, Rodolphe Jenatton, André Susano Pinto, Daniel Keysers, Neil Houlsby. Scaling Vision with Sparse Mixture of Experts. Tech report 2021

[33] Alec Radford, Jong Wook Kim, Chris Hallacy, Aditya Ramesh, Gabriel Goh, Sandhini Agarwal, Girish Sastry, Amanda Askell, Pamela Mishkin, Jack Clark, Gretchen Krueger, Ilya Sutskever. Learning Transferable Visual Models from Natural Language Supervision. Tech report 2021

[34] Aditya Ramesh, Mikhail Pavlov, Gabriel Goh, Scott Gray, Chelsea Voss, Alec Radford, Mark Chen, Ilya Sutskever. Zero-Shot Text-to-Image Generation. Tech report 2021